AI と研究開発の倫理: 責任を伴うイノベーション

人工知能 (AI) は、研究開発 (R&D) に革命をもたらしています。 データを分析し、パターンを発見し、複雑な問題に対する革新的なソリューションを開発するための新しい方法を提供しています。

この記事では、R&D における AI の倫理と、イノベーションと説明責任のバランスをとる方法について説明します。

研究開発における AI の役割

AI は、ヘルスケアから金融、エネルギーに至るまで、多くの業界を変革しています。 ヘルスケアにおける AI の用途には、創薬と開発、医用画像解析などがあります。

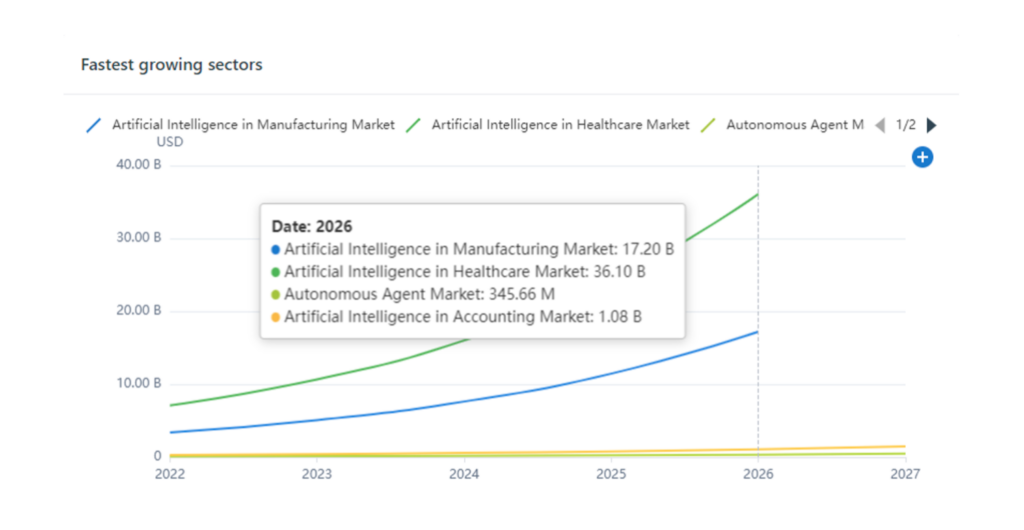

上のグラフが示すように、ヘルスケアにおける AI は、AI 市場で最も急速に成長している分野です。 AI が診断、治療、精度、結果、およびケアの質を改善することを考えると、これは驚くべきことではありません。

金融では、AI が金融データを分析して、より正確な市場予測を行います。 エネルギー分野では、AI は送電網の運用を最適化し、エネルギー生産の効率を向上させるのに役立ちます。 これらは、AI が研究開発を変革するさまざまな方法のほんの一例です。

研究開発における AI の利点

研究開発における AI の使用には、次のような多くの利点があります。

- 大規模なデータセットを迅速かつ正確に分析

- 人間の研究者には明らかでない可能性のあるパターンを特定する

- 特定のニーズに合わせたソリューションを開発します。

AI は、コストを削減し、R&D プロセスをスピードアップするのにも役立ちます。 これにより、研究者は新しい製品やソリューションをより迅速かつ効率的に開発できるようになります。

研究開発における AI によって提起される倫理的問題

ただし、R&D で AI を使用すると、多くの倫理的問題も生じます。 たとえば、AI システムによる意思決定の責任者は誰ですか? AI を使用して新薬を開発した場合、その薬に予期しない副作用が発生した場合、誰が責任を負うのでしょうか? 同様に、AI システムが採用を決定する場合、システムが特定のグループに対して偏っているとどうなるでしょうか?

もう XNUMX つの倫理的な懸念は、AI が有害な方法で使用される可能性です。 たとえば、AI は自律兵器の開発や、人々のプライバシー権を侵害する監視システムの作成に使用される可能性があります。

ChatGPT およびその他の AI ボットの使用における倫理的考慮事項

ChatGPT は、研究開発 (R&D) を含む幅広いアプリケーションに使用できる強力なツールです。 しかし、 ボットの使用 R&D における ChatGPT のように、考慮しなければならない重要な倫理的懸念も生じます。

1 倫理的な懸念 AI モデルのトレーニングに使用されるデータのバイアスの可能性です。 ChatGPT のトレーニングに使用されるデータに偏りや不完全性がある場合、AI モデルがその偏りを永続させ、不正確または不公平な予測を行う可能性があります。 これは、特に AI モデルが人々の生活に大きな影響を与える決定を下すために使用されている場合、重大な倫理的影響を与える可能性があります。

もう XNUMX つの倫理的な懸念は、意図しない結果が生じる可能性です。 AIモデルのように AI言語モデルを活用してコードのデバッグからデータの異常検出まで、 より強力で洗練されたものになると、人間の作成者の理解を超えたコンテンツを生成したり、決定を下したりできるようになる可能性があります。 これは、特に AI モデルがコンテンツを生成したり、有害または非倫理的な決定を下したりする場合に、倫理的なジレンマを生み出す可能性があります。

これらの倫理的懸念に対処するには、使用に関する明確な倫理的ガイドラインを確立することが重要です。 AI これには、プライバシー、データ保護、および意図しない結果に関する考慮事項が含まれます。 さらに、R&D における ChatGPT のような AI モデルの使用を定期的に評価して、それらが倫理的に使用され、個人や社会全体に意図しない悪影響を与えていないことを確認することが重要です。

イノベーションと説明責任のバランスを取る

間のバランス 革新 そして説明責任は、次のようないくつかの手段を通じて達成できます。

- 研究者やその他の利害関係者が意思決定がどのように行われているかを理解できるように、AI システムが透明で説明可能であることを確認します。

- 研究開発における AI の使用に関する基準とガイドラインを作成し、AI システムの設計と展開において倫理的な考慮事項が考慮されるようにします。

- 研究開発における AI の使用に関する倫理的考慮事項について、研究者やその他の利害関係者に教育とトレーニングを提供します。

- システムを開発するのが研究者であるか、それを実装するユーザーであるか、またはその両方であるかに関係なく、AI システムによって行われる決定に対して説明責任と責任があることを確認します。

まとめ

研究開発における AI の使用は大きなメリットをもたらしますが、対処しなければならない重要な倫理的問題も引き起こします。 イノベーションと説明責任のバランスを取ることで、研究者やその他の利害関係者は、倫理的配慮を損なうことなく、AI のメリットを確実に実現できます。 AI が研究開発を変革し続ける中、常に警戒を怠らず、AI が革新的かつ倫理的な方法で使用されるようにすることが重要です。